토니의 연습장

Pretrain, SFT, RL 본문

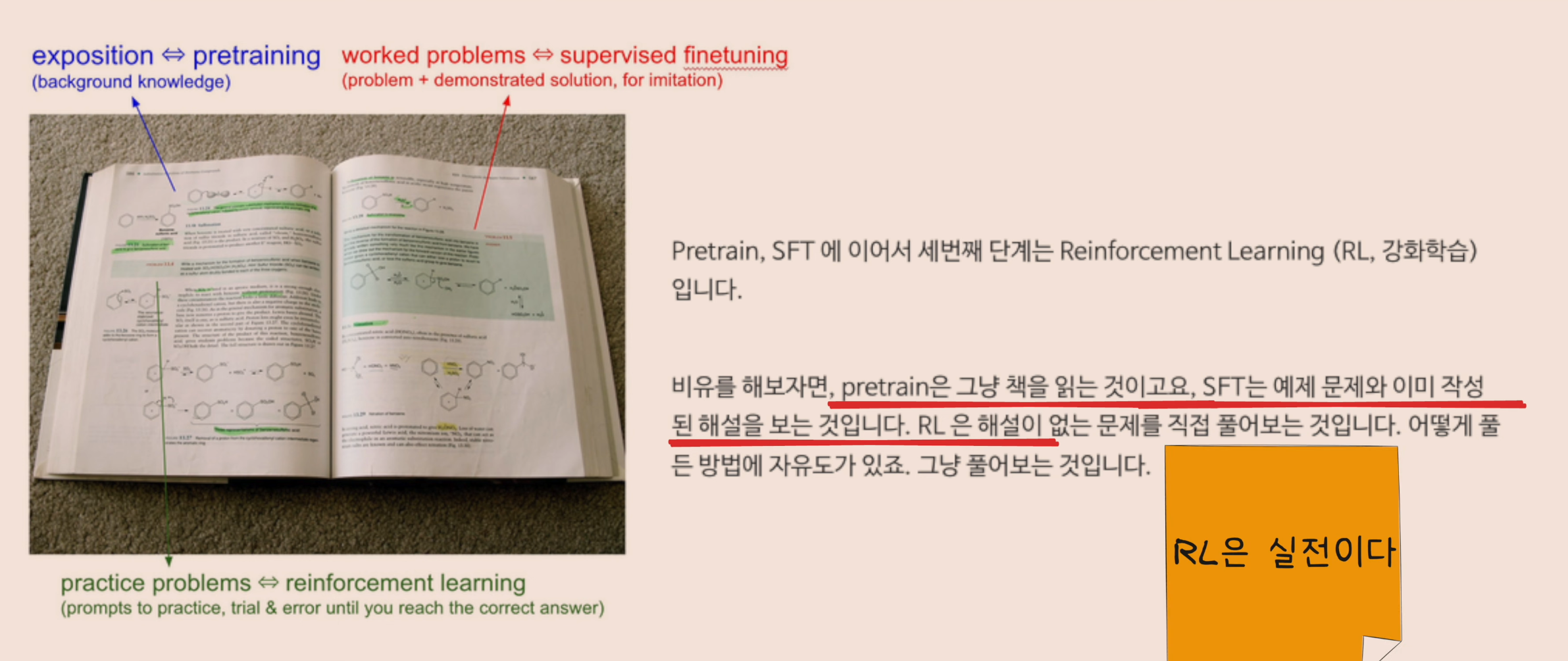

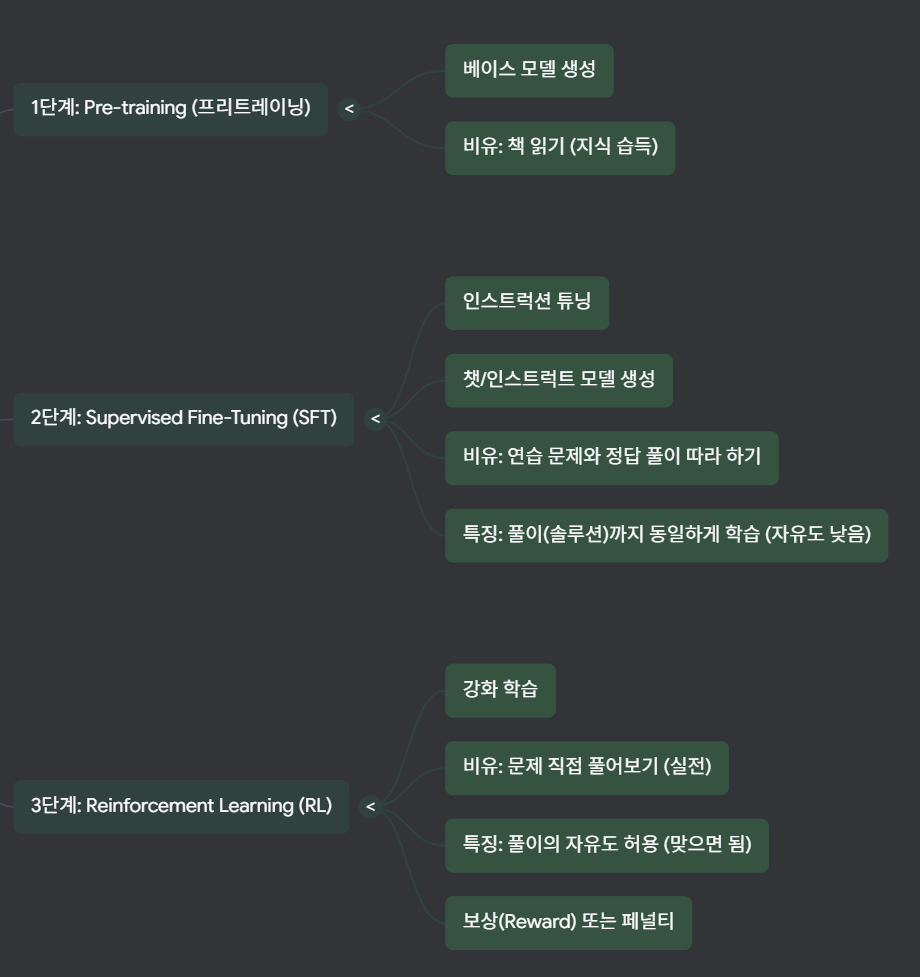

Pretraining -> SFT (Supervised Fine-Tuning) -> RL (Reinforcement Learning)

RL 을 하다보면, 기존에 없던 능력을 unlock 해내는 'aha moment' 가 생기는 것을 발견하게 됩니다.

Pretraining -> SFT (Supervised Fine-Tuning) -> RL (Reinforcement Learning)

<-

(distillation)

이제 강화 학습(RL)을 통해 추론 능력(reasoning capability)을 습득한 모델(R1)이 이제 그 능력을 다시 감독 학습(SFT)의 데이터로 활용하여 새로운 모델을 만드는 데 사용될 수 있습니다. 즉, RL을 통해 얻은 고급 능력을 SFT 과정을 통해 증류(Distillation)하는 것입니다.

참고 : https://youtu.be/kN5F0zu2wNA

'AI 일반 > 모델, 아키텍처, 구현' 카테고리의 다른 글

| MoE (Mixture of Experts) (0) | 2025.11.15 |

|---|---|

| GPT/Llama 아키텍처 (0) | 2025.09.18 |

| LLM train/eval/generate 간단한 예시 (0) | 2025.09.18 |

| RLHF / DPO (ft. Pretrained -> SFT -> Reward -> Final model) (0) | 2025.09.05 |

| SSL (Self-Supervised Learning) (1) | 2025.08.26 |