토니의 연습장

SAM-CLIP 본문

SAM-CLIP: Merging Vision Foundation Models towards Semantic and Spatial Understanding

https://arxiv.org/pdf/2310.15308v4

논문 개요

제목 : SAM-CLIP: Merging Vision Foundation Models towards Semantic and Spatial Understanding

저자/소속 : Haoxiang Wang (University of Illinois U-C, Apple Intern) 외 Apple 연구진

버전 / 날짜 : v4 - 2024-06-10 arXiv

1. 연구 동기 & 문제 정의

- CLIP은 텍스트-이미지 대비 학습으로 “무엇(semantic)”을 잘 파악하지만, 고해상도에 약하고 픽셀 단위 위치 정보가 빈약.

- SAM(Segment Anything Model)은 인스턴스 분할을 통해 “어디(spatial)”를 정확히 찾지만, 텍스트 의미 이해 능력이 거의 없음.

- 두 모델을 따로 돌리면 저장 공간·추론 계산량이 2배이고, 상호보완적 학습도 불가능.

- 기존 CLIP ViT를 SAM 해상도(1024 px 이상)로 쓰면 비효율이므로, SAM의 ViT-Det 백본을 출발점으로 삼아 두 모델의 능력을 하나로 합치는 방법을 제안. arXivar5iv

2. SAM-CLIP 구조

| 공유 이미지 백본 | SAM ViT-Det (B, L) 가중치로 초기화 → 고해상도 입력(1024 px)을 효율적으로 처리 |

| CLIP 헤드 | 이미지 특성을 텍스트 임베딩 공간으로 사상하는 프로젝션 MLP + OpenAI CLIP 텍스트 인코더 |

| SAM 헤드 | 원본 SAM의 마스크 디코더·프롬프트 인코더 그대로 유지 |

| 학습 파이프라인 | ① SAM 가중치 로드 → ② CLIP 헤드 추가 → ③ “계속학습(continual) + 지식 증류(distillation)”로 두 과제를 번갈아 미니배치 학습 |

핵심 아이디어: 원본 프리트레인 데이터를 10 %만 재사용하면서도, 리플레이(replay) 데이터와 멀티태스크 증류 손실로 **망각(catastrophic forgetting)**을 억제한다. ar5ivar5iv

3. 학습 세부 전략

- 데이터 준비

- 텍스트-이미지 페어: DataComp-1B, LAION-2B 중 1 % 샘플

- 분할 마스크: COCO / LVIS 일부 + SAM 자체 마스크 일부

- 손실 함수

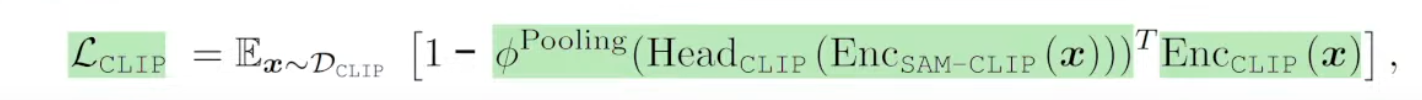

- CLIP 대비 학습 손실 L<sub>CLIP</sub>L<sub>CLIP</sub>

- SAM 인스턴스 분할 손실 L<sub>SAM</sub>L<sub>SAM</sub>

- 증류 손실 : 두 교사 모델(SAM, CLIP) 출력을 모방

- 최종 손실 : L=λ1LCLIP+λ2LSAM+λ3LdistillL = \lambda_{1}L_{CLIP} + \lambda_{2}L_{SAM} + \lambda_{3}L_{distill}

- 계속학습 스케줄

- Stage-1 : CLIP 작업 비중 ↑, SAM 리플레이 ↓

- Stage-2 : 두 작업 균형 → 파라미터 미세 조정

- 메모리·연산 절감

- 단일 백본 덕분에 추론 FLOPs 약 40 % 절감, 파라미터 수 2 → 1 모델 ar5iv

4. 실험 결과 (주요 벤치마크)

| Zero-shot Semantic Segmentation | Pascal-VOC | mIoU 66.0 % | +6.8 %p 기존 SOTA ar5iv |

| COCO-Stuff | mIoU 52.9 % | +5.9 %p | |

| Zero-shot Instance Segmentation | COCO / LVIS | SAM 수준 유지 (AP 차이 ≤ 0.3) | |

| Zero-shot Classification | ImageNet-1k (336 px) | Top-1 80.5 % | CLIP(DataComp1B) 81.3 % 대비 -0.8 % |

| Image-Text Retrieval | Flickr30k | R@1 94.0 % | CLIP 동급 |

결론: 본래 두 모델의 대표 과제 성능을 거의 유지하면서, 새로운 과제(텍스트 기반 의미 분할)에서 큰 폭으로 SOTA 달성 ar5iv

5. 분석 및 시사점

- 표현 풍부도 증가 : Head probing 실험에서 SAM-CLIP 백본이 spatial + semantic 특성을 모두 포착 → 추가 다운스트림 과제 적응력이 우수 ar5iv

- 경량 멀티태스크 모델 : Edge GPU/모바일 환경에서 메모리·추론 시간 반감—로컬 애플리케이션, AR 기기 등에 유리

- 범용 모델 병합 프레임워크 : 언어·음성·depth 등 서로 다른 목표로 학습된 Foundation Model들을 단계적으로 합칠 수 있는 일반 레시피 제시

6. 한계와 향후 과제

- 원본 데이터 일부(≈10 %) 접근 필요 → 프라이버시·라이선스 이슈가 남음

- CLIP Retrieval·분류에서 소폭 감소 : 추가 정밀 튜닝 or 어댑터 방식 연구 필요

- 다중 모달 병합 시 간섭 문제 : 더 다양한 조합(SAM + DINOv2, CLIP + Depth 모델 등)에서의 그라디언트 충돌 완화 기법 탐색

✍️ 정리

SAM-CLIP은 “고해상도 공간 인지” 능력을 가진 SAM과 “언어 의미 이해” 능력을 가진 CLIP을 단일 ViT-Det 백본으로 이어 붙여, 저장·추론 효율을 대폭 높이면서 서로의 강점을 상호 보완한다. 특히 텍스트 프롬프트만으로 장면을 분할하는 Zero-shot Semantic Segmentation에서 새로운 SOTA를 달성해 비정의(annotation-free) 시각 이해의 가능성을 확장했다.

수식 원문

1. 각 기호가 뜻하는 것

2. 무엇을 최소화하나?

- 벡터 내적(또는 코사인 유사도)이 1에 가까울수록 두 임베딩이 동일

- 손실을 1−1-유사도로 정의하면LCLIP ↓ ⟺ zs Tzt ↑ \mathcal{L}_{\text{CLIP}} \;\downarrow \;\Longleftrightarrow\; z_s^{\!T}z_t \;\uparrow즉 학생(SAM-CLIP) 임베딩을 교사(CLIP) 임베딩과 최대한 같게 만들도록 학습된다.

3. 왜 필요한가?

- 지식 증류(knowledge distillation)

- SAM-CLIP이 CLIP의 “텍스트-정렬 의미 정보”를 그대로 계승하도록 강제

- 공유 백본 한 개만 유지

- CLIP 별도 백본을 두지 않고도 분류·검색 성능을 보존

- 상호보완 특성 결합

- 이후에는 같은 임베딩으로 텍스트 조건 분할·이미지 검색 모두 수행 가능

4. 직관적 요약

“SAM-CLIP이 뽑아낸 이미지 표현이, 원래 CLIP이 뽑던 표현과 최대한 똑같아지도록

평균적으로( E\mathbb{E} ) 거리를 줄여나가는 손실 항.”

결국 이 수식은 SAM 기반 고해상도 백본에 CLIP의 의미 공간을 주입하는 핵심 메커니즘이다.

'AI 일반 > 논문, 구현' 카테고리의 다른 글

| LLAMAFACTORY: Unified Efficient Fine-Tuning of 100+ Language Models (0) | 2025.11.07 |

|---|---|

| Why Language Models Hallucinate (0) | 2025.09.16 |

| MiniGPT-4 (0) | 2025.05.26 |

| 딥러닝 논문 읽는 법 (0) | 2025.04.03 |

| ViT (Vision Transformer) 논문 구현하기 (0) | 2024.08.28 |